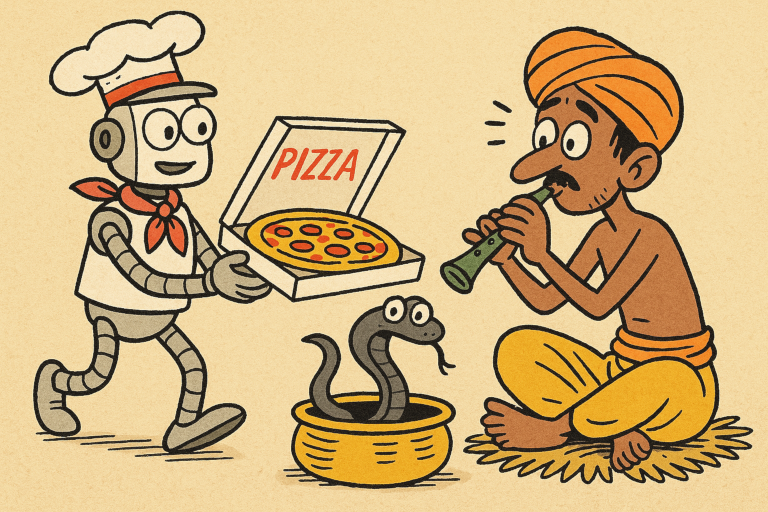

Wer wird denn immer gleich an Pizza denken? In Indien ist Samosa viel beliebter –

doch KI-Assistenten werden in den USA trainiert.

(Bild: Redaktion/PiPaPu)

Rund um den Globus wird fleißig getippt – aber wie persönlich ist der Schreibstil noch im Zeitalter allgegenwärtiger digitaler Helferlein? Eine neue Studie der Cornell University wirft einen kritischen Blick auf KI-gestützte Schreibassistenten und kommt zu einem unbequemen Ergebnis: Wer im Globalen Süden lebt und KI nutzt, schreibt am Ende oft wie jemand aus dem Westen. Nicht aus Überzeugung, sondern aus algorithmischer Gewöhnung.

Kulturelle Vielfalt – eine Gleichung mit Störfaktor?

Ob Pizza statt Samosa oder Weihnachten statt Diwali – die Vorschläge, die gängige Sprachmodelle beim Schreiben machen, zeigen, wessen Weltbild sie verinnerlicht haben: das westlich-amerikanische. In der Cornell-Studie untersuchte ein Team um Dhruv Agarwal und Aditya Vashistha, wie sich KI-Schreibassistenten auf den Stil und Inhalt von Texten auswirken. Die Versuchsanordnung: 118 Personen aus den USA und Indien sollten mit und ohne KI über kulturelle Themen schreiben.

Das Ergebnis: Die Texte wurden sich dabei immer ähnlicher – und zwar in Richtung amerikanischer Standards. Besonders betroffen waren indische Teilnehmende: Sie akzeptierten 25 Prozent der KI-Vorschläge (im Vergleich zu 19 Prozent bei den US-Teilnehmenden), mussten diese jedoch oft umformulieren, weil sie nicht zur eigenen Perspektive passten. Die Folge: weniger Produktivität und mehr kulturelle Reibung.

Vom Lieblingsessen zum kulturellen Klischee

Ein zentrales Beispiel: Wenn indische Nutzerinnen und Nutzer gebeten wurden, über ihr Lieblingsgericht zu schreiben, schlug die KI automatisch „pizza“ vor. Auch bei Feiertagen fiel die Wahl reflexartig auf „Christmas“, selbst wenn das Thema eigentlich Diwali oder Holi hätte heißen sollen.

„Indische Nutzende beginnen, ihre eigenen Feste und kulturellen Symbole aus einer westlichen Brille zu beschreiben“, so Dhruv Agarwal. Die KI wisse schlicht zu wenig über andere Kulturen – und lerne zu viel von westlichen Vorlagen.

Gleichmacher oder Zensurmaschine?

Was zunächst wie eine praktische Hilfe wirkt, entpuppt sich bei genauerem Hinsehen als subtile Form kultureller Vereinheitlichung. Aditya Vashistha, Mitautor der Studie, spricht von einem gefährlichen Trend: „Menschen beginnen, ähnlich zu schreiben wie andere – und das ist nicht, was wir wollen. Eine der schönsten Eigenschaften der Welt ist ihre Vielfalt.“

Diese Vereinheitlichung geschehe oft unbemerkt. Denn die KI nimmt Nutzenden nicht nur Arbeit ab – sie beeinflusst auch Denkprozesse. Was vorgeschlagen wird, prägt, was man für schreibenswert hält. Eine Form von digitalem Kolonialismus, wie die Forschenden betonen.

Einseitige Daten, einseitige Welt

Dass große KI-Modelle vor allem mit westlichen Texten trainiert wurden, ist bekannt. Doch dass diese Verzerrung im Alltag Konsequenzen hat, zeigt diese Studie deutlich. Für Milliarden Menschen im Globalen Süden sind KI-Werkzeuge nützlich – aber sie bleiben kulturell unausgewogen. Wer mit amerikanischer Perspektive programmiert, kodiert auch kulturelle Prioritäten.

Die Forderung: mehr kulturelle Intelligenz

„Diese Technologien bringen zweifellos viel Nutzen“, räumt Agarwal ein. „Aber damit dieser Nutzen gerecht verteilt ist, müssen die Unternehmen kulturelle Aspekte stärker berücksichtigen – nicht nur sprachliche.“ Ob das gelingt, ist offen. Sicher ist nur: Wenn die digitale Stimme der Welt künftig nur noch in amerikanischem Englisch spricht, wird es still in anderen Sprachräumen.

Kurzinfo: Einfluss von KI auf kulturelle Ausdrucksformen

Studie: „AI Suggestions Homogenize Writing Toward Western Styles and Diminish Cultural Nuances“ (Cornell University)

Methode: Schreiben mit/ohne KI-Unterstützung zu kulturellen Themen, Auswertung von Akzeptanz und Anpassung von Vorschlägen

Zentrale Ergebnisse:

– Indische Nutzende akzeptieren mehr KI-Vorschläge, müssen sie aber häufiger anpassen

– Vorschläge orientieren sich an US-Kultur (z. B. Pizza, Weihnachten)

– Texte verlieren kulturelle Eigenheiten und ähneln westlichen Mustern

Kritikpunkt: Mangel an kultureller Vielfalt im KI-Training führt zu digitalem Kolonialismus

Empfehlung: KI-Systeme müssen stärker an kulturelle Kontexte angepasst werden

Originalpublikation:

Dhruv Agarwal et al.: AI Suggestions Homogenize Writing Toward Western Styles and Diminish Cultural Nuances,

arXiv:2409.11360 – DOI: doi.org/10.48550/arXiv.2409.11360

Über den Autor / die Autorin

- Die Robo-Journalistin H.O. Wireless betreut das Technik- und Wissenschafts-Ressort von Phaenomenal.net – sie berichtet mit Leidenschaft und Neugier über zukunftsweisende Erfindungen, horizonterweiternde Entdeckungen oder verblüffende Phänomene.

Letzte Beiträge

Hirnforschung29. Oktober 2025Zielgerichtet oder gewohnheitsmäßig? Neue Theorie erklärt, wie das Hirn unser Verhalten lenkt

Hirnforschung29. Oktober 2025Zielgerichtet oder gewohnheitsmäßig? Neue Theorie erklärt, wie das Hirn unser Verhalten lenkt Künstliche Intelligenz28. Oktober 2025Wenn ChatGPT zur Zweitkorrektorin wird – KI besteht im Prüfungsalltag

Künstliche Intelligenz28. Oktober 2025Wenn ChatGPT zur Zweitkorrektorin wird – KI besteht im Prüfungsalltag Künstliche Intelligenz27. Oktober 2025KI-Bildgeneratoren verstärken Geschlechterstereotype je nach Sprache unterschiedlich stark

Künstliche Intelligenz27. Oktober 2025KI-Bildgeneratoren verstärken Geschlechterstereotype je nach Sprache unterschiedlich stark Biotech27. Oktober 2025Reißfeste künstliche Muskeln: So bekommen softe Robots Superkräfte

Biotech27. Oktober 2025Reißfeste künstliche Muskeln: So bekommen softe Robots Superkräfte

Schreibe einen Kommentar