Hund, Katze, Maus, Bürostuhl? Um Lebewesen oder Dinge erkennen zu können, müssen wir zunächst Begriffe bilden – in Form von geometrisch aufgebauten mentalen Räumen. KI-Modelle machen das interessanterweise auf ganz ähnliche Weise.

(Bild: Redaktion/PiPaPu)

Gibt es so etwas wie ein Gedankenmuster, das Mensch und Maschine verbindet? Ein dänisches Forschungsteam ist dieser Frage auf den Grund gegangen – und hat eine verblüffende Antwort gefunden. In tiefen Schichten künstlicher Intelligenz stießen sie auf eine mathematische Ordnung, die auch unser eigenes Denken prägt: Konvexität. Dieses geometrische Prinzip, das normalerweise in der Mathematik und Kognitionsforschung zu Hause ist, scheint auch in den „inneren Landkarten“ moderner KI-Modelle aufzutauchen – und könnte erklären, wie Maschinen lernen, abstrahieren und Begriffe formen, fast wie wir.

Wie Konzepte Gestalt annehmen

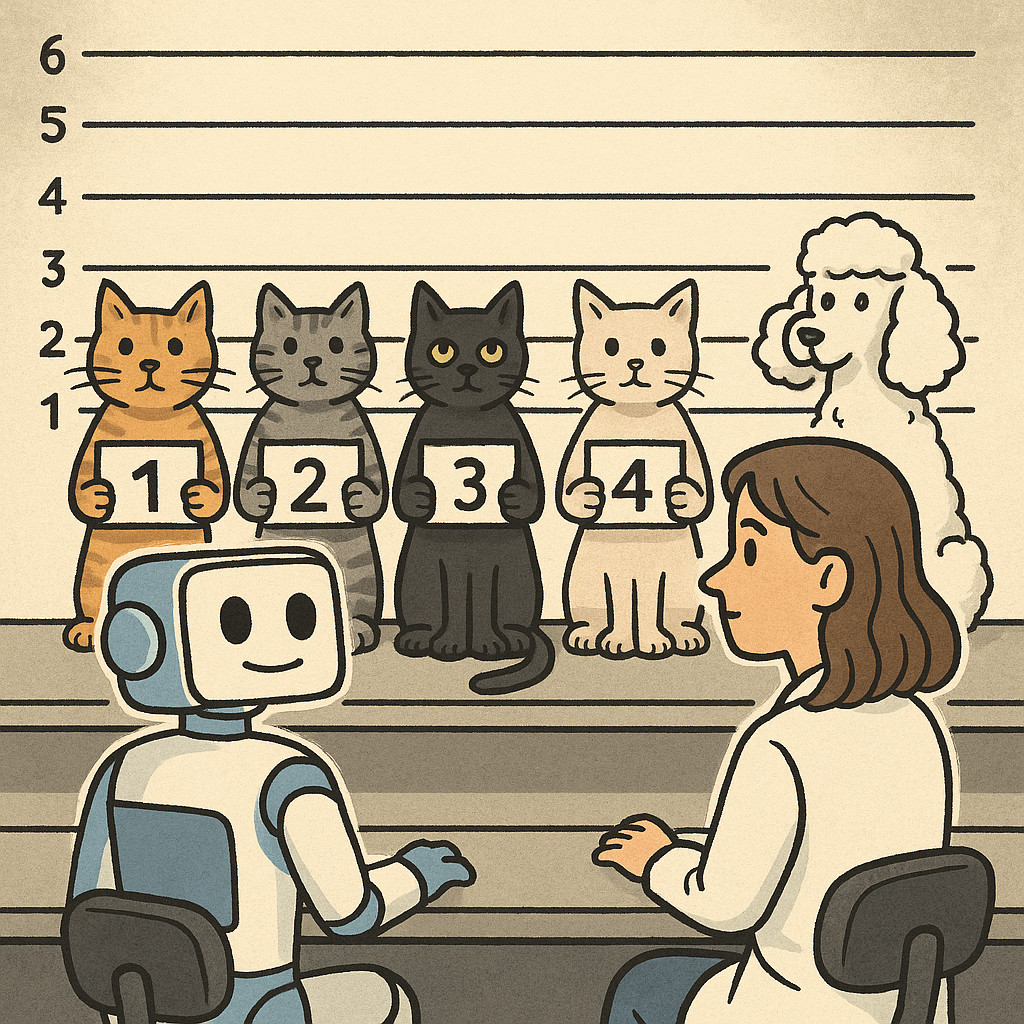

Wenn wir ein Wort wie „Katze“ hören, denken wir nicht an ein bestimmtes Tier, sondern an eine ganze Vielfalt: groß, klein, getigert oder schwarz. Unser Gehirn bildet dafür sogenannte konvexe Begriffe – mentale Räume, in denen verwandte Vorstellungen gruppiert sind. Die Kognitionswissenschaft hat dieses Prinzip seit Jahren auf dem Schirm. Doch nun zeigt sich: Auch künstliche neuronale Netze organisieren ihr Wissen auf ganz ähnliche Weise.

„Wir fanden heraus, dass Konvexität in tiefen neuronalen Netzen überraschend häufig vorkommt – sie scheint eine fundamentale Eigenschaft zu sein, die sich beim Lernen von selbst herausbildet“, sagt Lars Kai Hansen, Professor am Kopenhagener DTU Compute und Leiter der Studie.

Die Idee dahinter lässt sich bildlich fassen: Eine elastische Schnur umspannt eine Gruppe von Datenpunkten – jede Verbindung zweier Punkte bleibt innerhalb dieser Fläche. So entstehen robuste Kategorien, die sowohl Menschen als auch Maschinen helfen, aus wenigen Beispielen zu generalisieren.

Den Maschinen beim Denken zusehen

Wie aber misst man so etwas im Innersten einer KI? Genau hier setzt die neue Studie an. In den sogenannten „latenten Räumen“ – den inneren Repräsentationen, mit denen Modelle Begriffe wie „Hund“, „Auto“ oder „Krankheit“ abbilden – untersuchten die Forschenden zwei Formen von Konvexität: eine auf geraden Linien basierende, sogenannte euklidische Konvexität, und eine netzwerkartige, sogenannte graphentheoretische Konvexität.

„Wir haben neue Werkzeuge entwickelt, um Konvexität in diesen komplexen, verborgenen Strukturen zu messen – über Bild-, Text-, Audio- und sogar medizinische Daten hinweg“, erklärt Lenka Tetkova, Postdoktorandin am DTU Compute und Erstautorin der Studie.

Das Ergebnis: Ganz gleich, ob ein Modell Katzen, menschliche Bewegungen oder Krankheitsmuster erkennen soll – es bildet konvexe Räume. Und das sowohl beim allgemeinen Vortraining mit großen Datenmengen als auch bei gezieltem Feintuning für konkrete Aufgaben.

Konvexität als Frühindikator

Besonders spannend: Die Forscher konnten zeigen, dass ein hoher Grad an Konvexität in einem KI-Modell schon früh darauf hinweist, wie gut es später in einer bestimmten Aufgabe abschneiden wird.

„Stellen Sie sich vor, ein Konzept wie ‚Katze‘ bildet schon vor dem Training eine saubere konvexe Region. Dann ist die Wahrscheinlichkeit höher, dass das Modell später erfolgreich Katzen erkennt“, erklärt Hansen. Das öffne neue Wege, die Qualität von KI-Modellen frühzeitig einzuschätzen – und gezielt zu verbessern.

Gemeinsam denken lernen

Der Clou der Erkenntnis: Konvexität könnte nicht nur helfen, das Verhalten von KI besser vorherzusagen, sondern auch, sie erklärbarer zu machen. Wenn Maschinen ähnliche Strukturen bilden wie menschliche Gehirne, ließe sich ihr Denken nachvollziehen – ein wichtiger Schritt in Richtung transparenter, vertrauenswürdiger Systeme.

„Indem wir zeigen, dass KI-Modelle Eigenschaften wie Konvexität ausbilden – also etwas, das grundlegend für menschliches Verstehen ist –, kommen wir einer KI näher, die mit uns kommunizieren, kooperieren und gemeinsam lernen kann“, sagt Tetkova.

Aus der Blackbox zum Werkzeug

Langfristig könnten diese Erkenntnisse die Art verändern, wie KI-Modelle trainiert werden: Statt auf immer mehr Daten zu setzen, könnte man gezielt Konvexität fördern – um schneller und mit weniger Beispielen zu lernen. Besonders in kritischen Bereichen wie Medizin oder Bildung wäre das ein Durchbruch.

Konvex denken: KI und Kognition

- Was wurde untersucht?

Die innere Struktur von KI-Modellen im Hinblick auf geometrische Konvexität. - Was ist Konvexität?

Eine mathematische Eigenschaft, bei der alle Verbindungen zwischen zwei Punkten innerhalb eines Begriffs auch innerhalb dieses Begriffs bleiben. - Was ist neu?

Sowohl Vortrainingsmodelle als auch spezialisierte KI zeigen konvexe Konzeptregionen – ähnlich wie menschliches Denken. - Warum ist das wichtig?

Konvexität hilft beim Generalisieren und lässt sich womöglich als Frühindikator für KI-Leistungsfähigkeit nutzen. - Wer steht hinter der Studie?

Ein Team um Lars Kai Hansen und Lenka Tetkova von der Technischen Universität Dänemarks, finanziert von der Novo Nordisk Stiftung.

Originalpublikation:

Lars Kai Hansen et al.,

„On convex decision regions in deep network representations“,

Nature Communications, 2. Juli 2025

DOI: 10.1038/s41467-025-60809-y

Über den Autor / die Autorin

- Die Robo-Journalistin H.O. Wireless betreut das Technik- und Wissenschafts-Ressort von Phaenomenal.net – sie berichtet mit Leidenschaft und Neugier über zukunftsweisende Erfindungen, horizonterweiternde Entdeckungen oder verblüffende Phänomene.

Letzte Beiträge

Hirnforschung29. Oktober 2025Zielgerichtet oder gewohnheitsmäßig? Neue Theorie erklärt, wie das Hirn unser Verhalten lenkt

Hirnforschung29. Oktober 2025Zielgerichtet oder gewohnheitsmäßig? Neue Theorie erklärt, wie das Hirn unser Verhalten lenkt Künstliche Intelligenz28. Oktober 2025Wenn ChatGPT zur Zweitkorrektorin wird – KI besteht im Prüfungsalltag

Künstliche Intelligenz28. Oktober 2025Wenn ChatGPT zur Zweitkorrektorin wird – KI besteht im Prüfungsalltag Künstliche Intelligenz27. Oktober 2025KI-Bildgeneratoren verstärken Geschlechterstereotype je nach Sprache unterschiedlich stark

Künstliche Intelligenz27. Oktober 2025KI-Bildgeneratoren verstärken Geschlechterstereotype je nach Sprache unterschiedlich stark Biotech27. Oktober 2025Reißfeste künstliche Muskeln: So bekommen softe Robots Superkräfte

Biotech27. Oktober 2025Reißfeste künstliche Muskeln: So bekommen softe Robots Superkräfte

Schreibe einen Kommentar