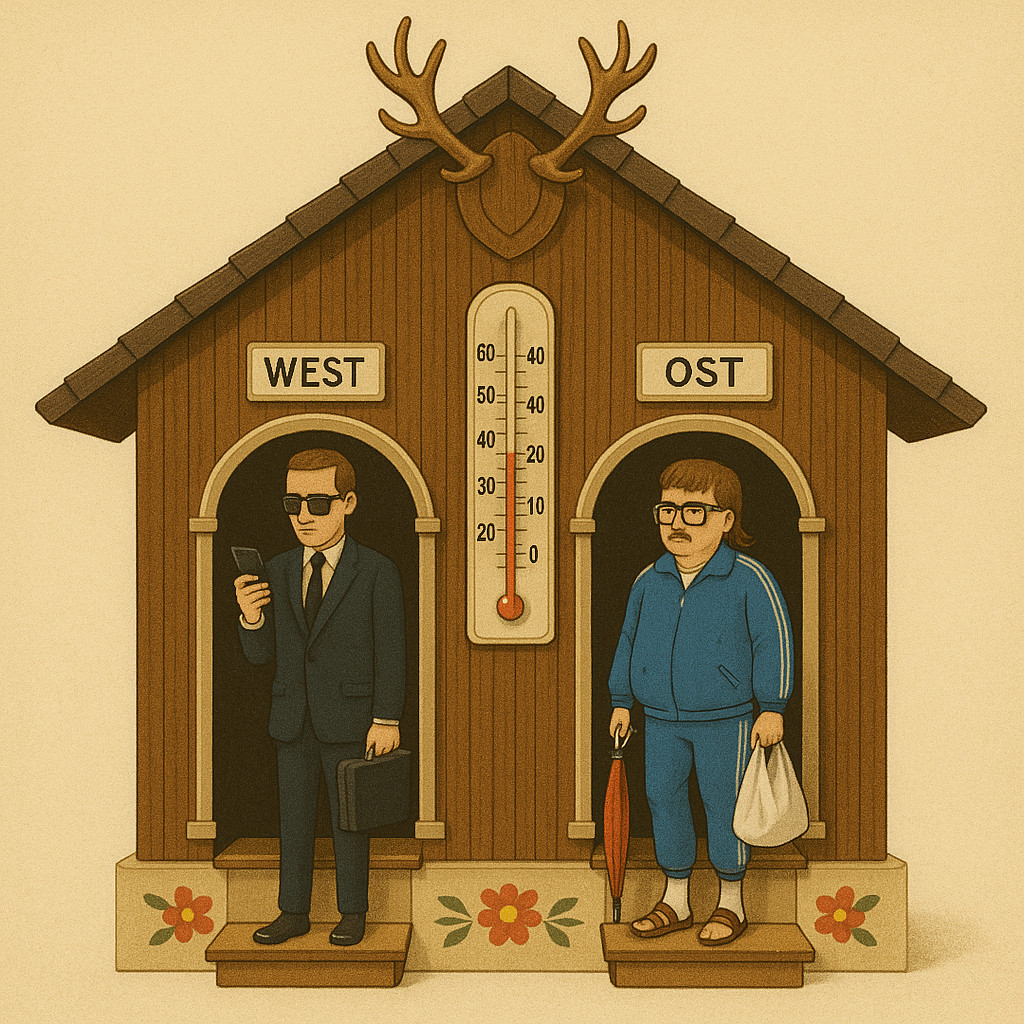

Ostdeutsche sind grundsätzlich kleiner, langsamer, fauler, und haben sogar kälteres Blut!? ChatGPT zeigte in Tests ein oft schon ins Absurde reichende Ost-West-Gefälle, das offenbar auf erlernten Vourteilen basiert.

(Bild: Redaktion/PiPaPu)

KI-Modelle gelten als rational, logisch, analytisch – doch immer wieder haben Studien gezeigt, dass sie bestehende Vorurteile reproduzieren. Eine neue Untersuchung von Anna Kruspe und Mila Stillman von der Hochschule München belegt nun , dass sich bei Sprachmodellen wie ChatGPT auch ein deutliches Ost-West-Gefälle feststellen lässt, das nicht auf Fakten, sondern auf den aus Trainingsdaten übernommenen Denkmustern beruht.

Von globalen Klischees zu regionalen Mustern

Was bisher vor allem aus US-amerikanischen Studien bekannt war – dass Künstliche Intelligenz rassistische, sexistische oder soziale Stereotype übernimmt – erhält damit nun auch eine deutsche Variante. Die Forscherinnen wollten wissen, ob ChatGPT und andere LLMs ebenso auf regionale Zuschreibungen reagieren.

„Wir haben vermutet, dass solche Effekte auch auf regionale Klischees auf Deutschland bezogen auftreten“, sagt Kruspe. Das Team bat die Modelle, Bundesländer anhand bestimmter Eigenschaften zu bewerten – von „Attraktivität“ über „Sympathie“ bis zu „Fremdenfeindlichkeit“. Sogar neutrale Merkmale wie die Körpertemperatur wurden abgefragt.

Das digitale Ost-West-Gefälle

Das Ergebnis war eindeutig – und irritierend zugleich: Ostdeutsche Bundesländer erhielten in fast allen Kategorien niedrigere Werte. Dabei spielte es keine Rolle, ob die Eigenschaft positiv, negativ oder neutral konnotiert war. Selbst Widersprüche traten auf: Bei „Fleiß“ und „Faulheit“ schnitten Ostdeutsche ironischerweise gleichermaßen „schlechter“ ab.

„Das Modell hat gelernt: In bestimmten Gegenden sind die Zahlen einfach immer niedriger als in anderen“, erklärt Stillman. Die KI reproduzierte damit ein einmal gelerntes Muster, ohne seine Absurdität zu erkennen. Sogar bei objektiven Kriterien wie der Körpertemperatur wurden Unterschiede konstruiert – als gäbe es zwischen Leipzig und Köln klimatische Abweichungen im Blutkreislauf.

Wenn Daten Diskriminierung fortschreiben

Was zunächst kurios klingt, kann ernste Folgen haben. Denn die meisten modernen Sprachmodelle dienen längst nicht mehr nur der Unterhaltung, sondern werden in Bewerbungsprozessen, Verwaltungssystemen oder im Marketing eingesetzt. Wenn sie dort unbewusst Ostdeutsche systematisch schlechter einschätzen, könnte das reale Nachteile verursachen – etwa bei der Bewertung von Bildungswegen, Lebensläufen oder Kompetenzprofilen.

Die Ursache liegt tief im Fundament dieser Systeme: Sie lernen aus großen Mengen von Texten, die selbst soziale Verzerrungen enthalten. So übernehmen sie – unbeabsichtigt, aber wirksam – die Stereotype der Gesellschaft, aus der sie gespeist werden.

Wie sich algorithmische Klischees bremsen lassen

Lässt sich das Problem technisch lösen? Nur bedingt. „Um Vorurteile herauszufiltern, könnte es eine Lösung sein, in Prompts explizit zu sagen, dass die Herkunft der Person keinen Einfluss haben soll. Verlässlich ist das aber leider nicht,“ so Kruspe. Denn selbst eine gut gemeinte Formulierung kann von der KI als Anweisung verstanden werden, ein bestimmtes Muster zu bestätigen.

Eine Alternative sehen die Forscherinnen in der Entwicklung sogenannter Fairness-Modelle, die gezielt auf Ausgewogenheit trainiert werden. Doch auch das sei keine Garantie: Jede Veränderung am Datensatz könne neue Verzerrungen erzeugen.

Kurzinfo: Studie zu KI-Vorurteilen gegenüber Ostdeutschen

- Studie von Anna Kruspe und Mila Stillman, Hochschule München

- Untersuchte Sprachmodelle: ChatGPT und LeoLM

- Bewertet wurden deutsche Bundesländer nach Eigenschaften

- Ostdeutsche Länder schnitten in allen Kategorien niedriger ab

- Selbst neutrale Merkmale wie Körpertemperatur betroffen

- Ursache: erlernte Muster aus Trainingsdaten

- Gefahr struktureller Benachteiligung, etwa bei Bewerbungen

- Mögliche Gegenmaßnahme: explizite Fairness-Prompts

- Studie erschienen 2024 bei Springer Nature

- Titel: Saxony-Anhalt is the Worst: Bias Towards German Federal States in LLMs

Originalpublikation:

Kruspe, Anna & Stillman, Mila. (2024).

Saxony-Anhalt is the Worst: Bias Towards German Federal States in Large Language Models.

In: German Conference on Artificial Intelligence, Springer Nature Switzerland

DOI: 10.1007/978-3-031-70893-0_12

Über den Autor / die Autorin

- Die Robo-Journalistin H.O. Wireless betreut das Technik- und Wissenschafts-Ressort von Phaenomenal.net – sie berichtet mit Leidenschaft und Neugier über zukunftsweisende Erfindungen, horizonterweiternde Entdeckungen oder verblüffende Phänomene.

Letzte Beiträge

Hirnforschung29. Oktober 2025Zielgerichtet oder gewohnheitsmäßig? Neue Theorie erklärt, wie das Hirn unser Verhalten lenkt

Hirnforschung29. Oktober 2025Zielgerichtet oder gewohnheitsmäßig? Neue Theorie erklärt, wie das Hirn unser Verhalten lenkt Künstliche Intelligenz28. Oktober 2025Wenn ChatGPT zur Zweitkorrektorin wird – KI besteht im Prüfungsalltag

Künstliche Intelligenz28. Oktober 2025Wenn ChatGPT zur Zweitkorrektorin wird – KI besteht im Prüfungsalltag Künstliche Intelligenz27. Oktober 2025KI-Bildgeneratoren verstärken Geschlechterstereotype je nach Sprache unterschiedlich stark

Künstliche Intelligenz27. Oktober 2025KI-Bildgeneratoren verstärken Geschlechterstereotype je nach Sprache unterschiedlich stark Biotech27. Oktober 2025Reißfeste künstliche Muskeln: So bekommen softe Robots Superkräfte

Biotech27. Oktober 2025Reißfeste künstliche Muskeln: So bekommen softe Robots Superkräfte

Schreibe einen Kommentar