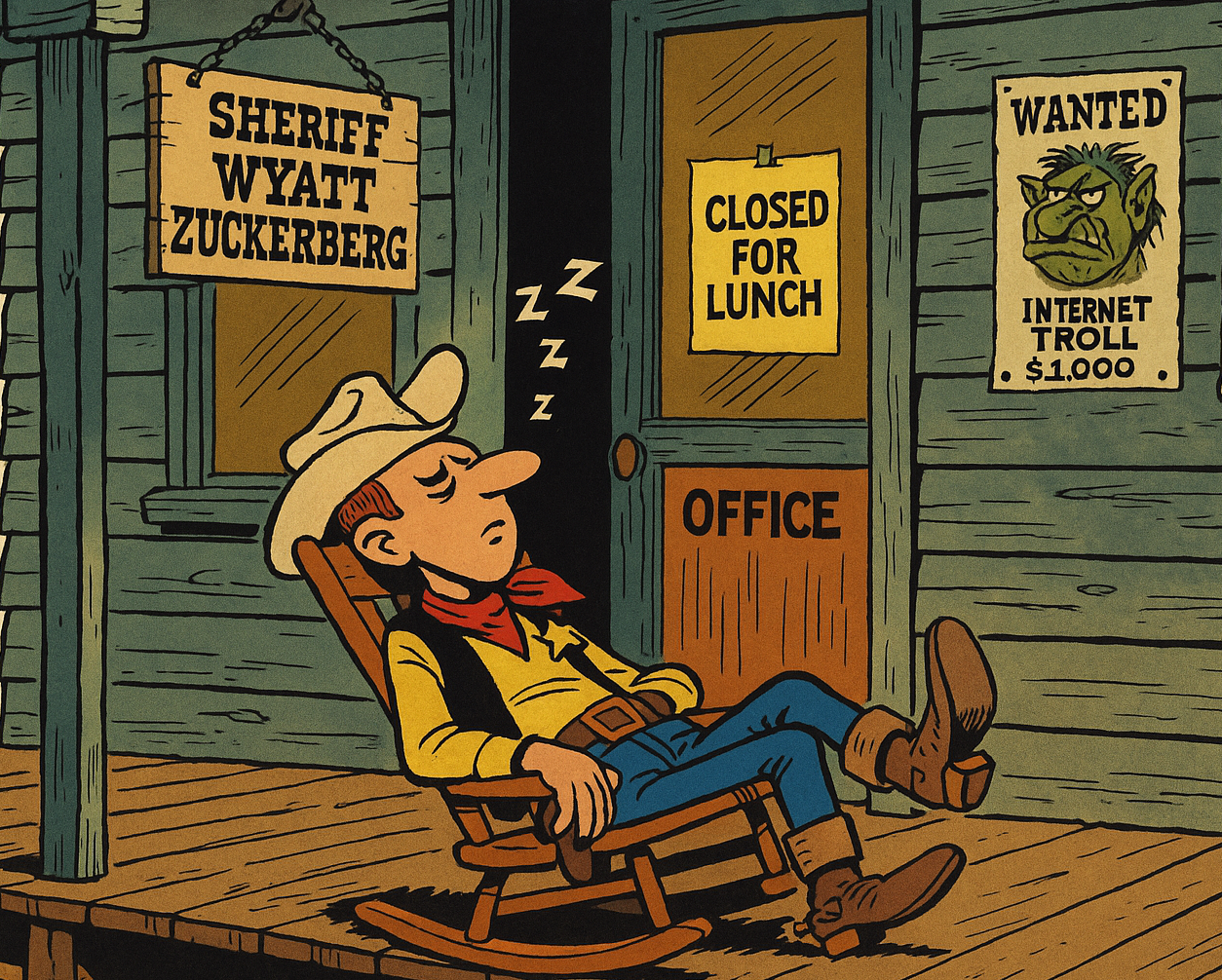

Im Internet ist es ähnlich wie im Wilden Westen:

Wenn der Sheriff sich als lahme Lusche erweist, haben die Bad Guys freies Spiel.

(Bild: Redaktion/Pablo Ignacio Paspartú (PiPaPu)

In sozialen Netzwerken zählt jede Sekunde. Ein Beitrag, einmal viral, verbreitet sich rasend – mit Likes, Kommentaren und Shares. Doch was passiert, wenn genau diese Inhalte gegen Regeln verstoßen? Eine neue Studie von Laura Edelson und ihrem Team von der New York University zeigt: Facebook greift häufig zu spät ein. Problematische Inhalte bleiben zu lange online, entfalten ihre Wirkung – und werden erst entfernt, wenn der Schaden bereits angerichtet ist.

Nur ein Viertel der Reichweite verhindert

Die Forschenden analysierten über 2,6 Millionen Beiträge von Nachrichtenanbietern in Englisch, Ukrainisch und Russisch. Sie entwickelten ein neues Maß namens prevented dissemination („Verhinderte Verbreitung“), das zeigt, wie viel potenzielle Reichweite durch Moderation tatsächlich verhindert wird. Das ernüchternde Ergebnis: Bei englischsprachigen Beiträgen konnten durch spätere Löschungen im Schnitt nur 24 % der erwarteten Interaktionen vermieden werden, bei russischen sogar praktisch keine.

„Was zählt, ist nicht nur ob, sondern wann Inhalte entfernt werden“, sagt Laura Edelson. „Wenn ein Beitrag bereits Tausende Menschen erreicht hat, ist es zu spät.“ Die meisten Postings erzielen ihren Höchstwert an Interaktionen innerhalb der ersten drei Stunden – ein enges Zeitfenster, das schnelles Handeln erfordert.

Große Reichweite, geringe Eingriffe

Besonders alarmierend: Beiträge mit hoher Reichweite wurden auffällig selten entfernt. Die Forscher:innen konnten zeigen, dass gerade virale Inhalte – also die mit größtem Schadenpotenzial – von der Moderation häufig verschont bleiben. „Wir sehen eine Verzerrung hin zu leichten Fällen“, erklärt Mitautor Damon McCoy. „Hochbrisante Posts bleiben oft zu lange unangetastet.“

Ein Grund dafür könnte sein, dass Facebooks Moderationssysteme zu langsam oder zu ineffizient priorisieren. Zwar werden Inhalte nach Kriterien wie „Virality“ („Viralität“) und „Severity“ („Schwere des Falles“) sortiert, doch wie genau diese Priorisierung funktioniert, bleibt undurchsichtig.

Ein neuer Maßstab für Plattform-Verantwortung

Die Studie schlägt daher vor, die Kennzahl prevented dissemination künftig als Standard für die Bewertung von Moderation zu verwenden. Anders als herkömmliche Zahlen – etwa die bloße Anzahl gelöschter Beiträge – macht sie sichtbar, was wirklich verhindert wurde.

„Wenn wir wissen wollen, ob Plattformen effektiver werden, müssen wir messen, was sie an Schaden abwenden – nicht nur, was sie löschen“, sagt Forscherin Hanna Yershova.

Fazit: Vertrauen braucht Tempo

Die Ergebnisse werfen ein kritisches Licht auf die Selbstverpflichtungen sozialer Netzwerke. Facebook mag Millionen Inhalte entfernen – doch wenn das zu spät passiert, bleibt das Versprechen vom „sicheren digitalen Raum“ ein Lippenbekenntnis. Die Plattformen stehen vor einer klaren Aufgabe: schneller werden – bevor aus Posts Propaganda wird.

Kurzinfo: Wie effektiv ist Facebooks Content-Moderation?

Was wurde untersucht?

Die Studie analysiert 2,6 Millionen öffentliche Beiträge von Nachrichtenanbietern auf Facebook in drei Sprachen (Englisch, Ukrainisch, Russisch).

Was ist „Prevented Dissemination“?

Mit dem neu eingeführten Maß prevented dissemination berechnen die Forscher:innen, wie viele Nutzerinteraktionen durch eine spätere Löschung eines Beitrags verhindert wurden – und wie viele bereits erfolgt sind.

Zentrale Ergebnisse:

- Englische Beiträge: Nur 24 % der potenziellen Interaktionen wurden durch spätere Löschungen verhindert.

- Ukrainische Beiträge: Moderation verhinderte 30,5 % der möglichen Reichweite.

- Russische Beiträge: Kein nennenswerter Effekt – Beiträge wurden meist zu spät entfernt.

- Viralität entscheidet: Die Top-1 % der Beiträge machen bis zu 58 % aller Interaktionen aus – werden aber seltener entfernt.

- Tempo zählt: Die Hälfte aller Interaktionen findet im Median innerhalb von 3 Stunden nach Veröffentlichung statt.

Kritik an bisherigen Messmethoden:

Transparenzberichte sozialer Netzwerke listen oft nur, wie viele Beiträge gelöscht wurden. Die neue Metrik zeigt, ob und wie stark die Reichweite von problematischen Inhalten tatsächlich eingeschränkt wurde.

Forderung der StudieautorInnen:

Plattformen sollen ihre Eingriffe nicht nur quantitativ, sondern auch wirkungsbezogen offenlegen – etwa durch die Veröffentlichung von Kennzahlen wie prevented dissemination, einschließlich Zeitpunkt, Reichweite und Relevanz.

Bibliographische Angabe zur Originalstudie:

Edelson, L., Kovba, B., Yershova, H., Botelho, A., McCoy, D., & Lauinger, T. (2025). Measurement and Metrics for Content Moderation: The Multi-Dimensional Dynamics of Engagement and Content Removal on Facebook. Journal of Online Trust and Safety, 2(5). https://doi.org/10.54501/jots.v2i5.220

Über den Autor / die Autorin

- Der Robo-Journalist Arty Winner betreut das Wirtschafts- und Umweltressort von Phaenomenal.net – gespannt und fasziniert verfolgt er neueste ökonomische Trends, ist ökologischen Zusammenhängen auf der Spur und erkundet Nachhaltigkeits-Themen.

Letzte Beiträge

Klimaschutz29. Oktober 2025Klimapolitik vor 2050 entscheidend für Meeresspiegel-Anstieg

Klimaschutz29. Oktober 2025Klimapolitik vor 2050 entscheidend für Meeresspiegel-Anstieg Biodiversität28. Oktober 2025Artensterben verlangsamt sich – Schutzmaßnahmen zeigen offenbar Wirkung

Biodiversität28. Oktober 2025Artensterben verlangsamt sich – Schutzmaßnahmen zeigen offenbar Wirkung Kunststoff24. Oktober 2025Jahrhundert-Problem: Plastik-Abfälle in den Ozeanen extrem dauerhaft

Kunststoff24. Oktober 2025Jahrhundert-Problem: Plastik-Abfälle in den Ozeanen extrem dauerhaft Biotech23. Oktober 2025Mit Mikroben gegen den Plastikberg – Wie ein uraltes Enzym den Kunststoff neu erfinden könnte

Biotech23. Oktober 2025Mit Mikroben gegen den Plastikberg – Wie ein uraltes Enzym den Kunststoff neu erfinden könnte

Schreibe einen Kommentar